问题描述

NextChat已经有很多人在使用了,它丝滑的交互体验,是调用OpenAI大模型的首选UI程序。在国内,我们有很大一部分人是调用的中转API,基本都是通过one-api、new-api等程序转发过来的,输出格式无论是gpt、gemini还是claude,都采用了统一的OpenAI兼容格式。

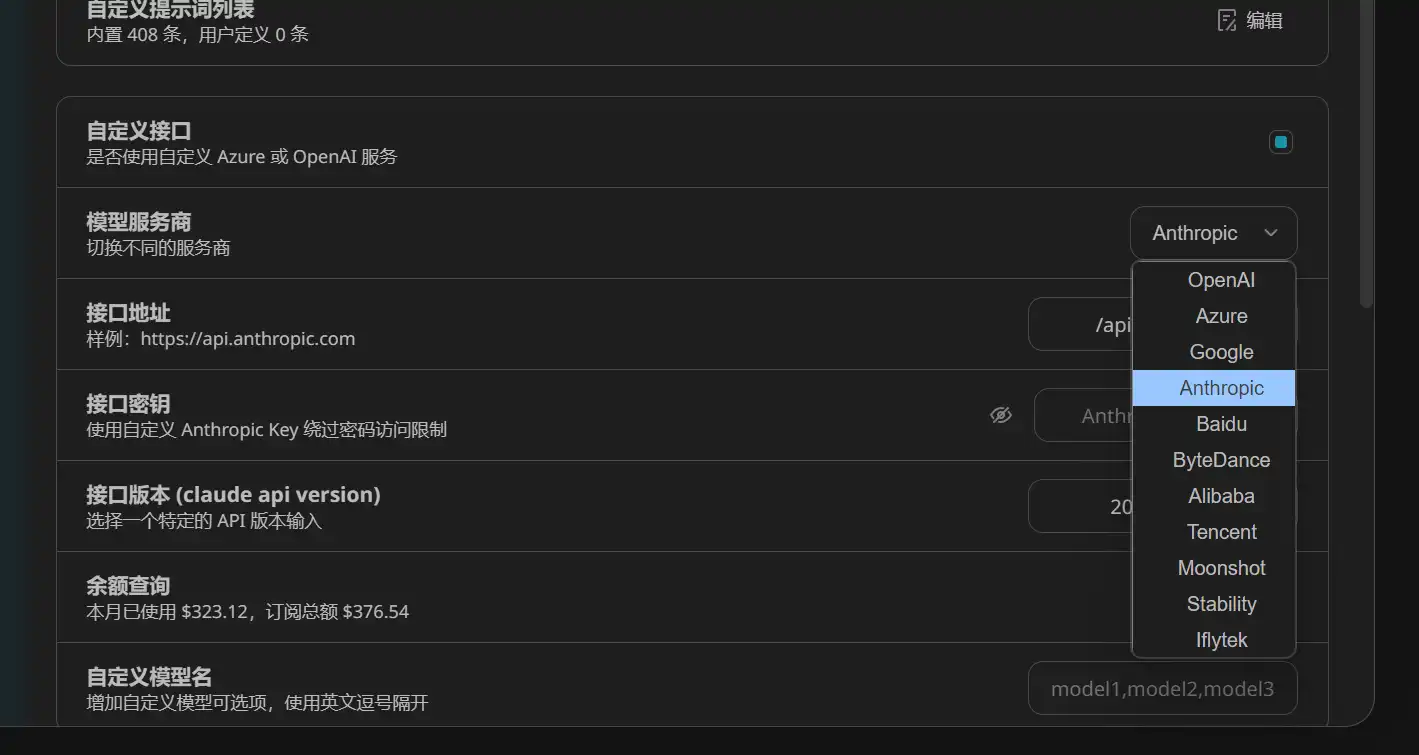

但是从某个版本开始,兼容格式的Claude模型在NextChat变得无法使用,因为NextChat在设置中加入了Anthropic的官方对接格式,当程序识别到Claude模型时会自动走Anthropic格式,从而导致走OpenAI兼容格式的Claude报错。

随着版本的更新,NextChat已经帮助用户解决了该问题,只是在官方开源程序中未明确说明如何使用。

解决方法

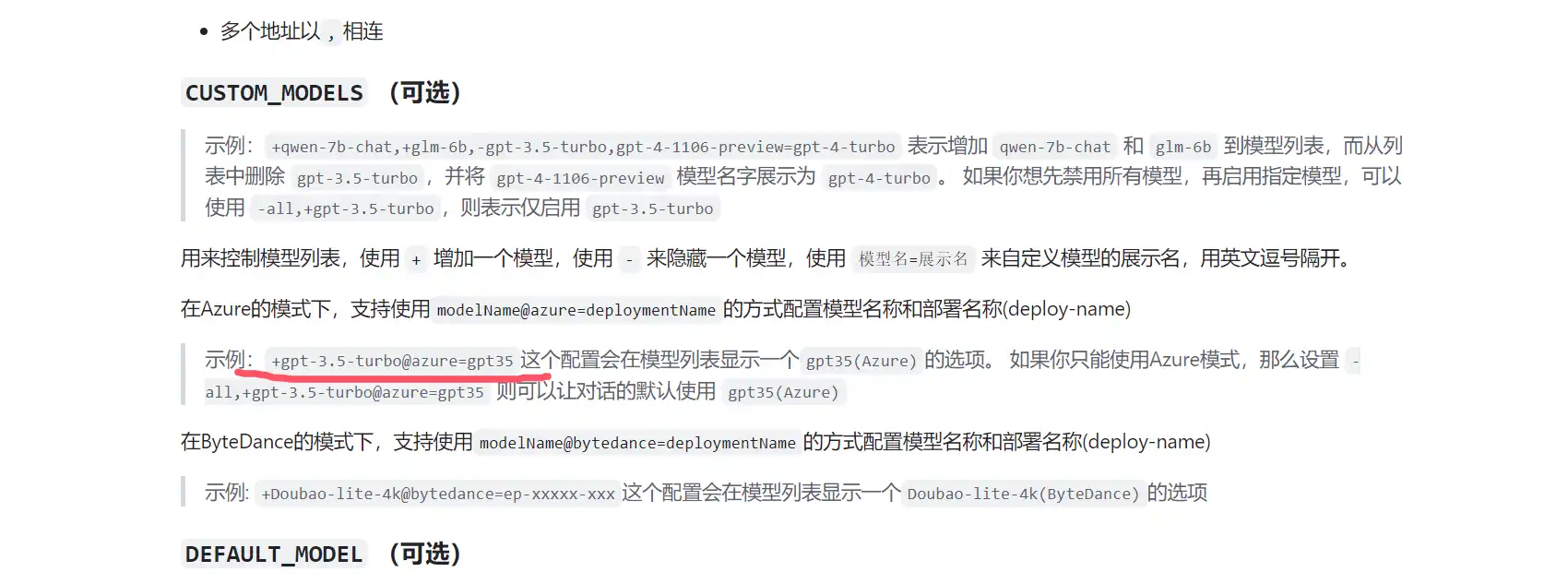

+claude-3-5-sonnet-20240620@openai=claude-3-5-sonnet-20240620

在Vecel部署中,把常用的模型都填进去并部署,成功!

-all,+gpt-3.5-turbo@openai=gpt-3.5-turbo,+gpt-4o@openai=gpt-4o,+gpt-4o-2024-08-06@openai=gpt-4o-2024-08-06,+gpt-4-turbo@openai=gpt-4-turbo,+gpt-4-turbo-2024-04-09@openai=gpt-4-turbo-2024-04-09,+gpt-4-turbo-preview@openai=gpt-4-turbo-preview,+gpt-4-1106-preview@openai=gpt-4-1106-preview,+gpt-4-0125-preview@openai=gpt-4-0125-preview,+gpt-4o-mini@openai=gpt-4o-mini,+gpt-4-all@openai=gpt-4-all,+llama-3.1-405b@openai=llama-3.1-405b,+llama-3.1-70b@openai=llama-3.1-70b,+llama-3.1-8b@openai=llama-3.1-8b,+claude-3-opus-20240229@openai=claude-3-opus-20240229,+claude-3-5-sonnet-20240620@openai=claude-3-5-sonnet-20240620,+claude-3-haiku-20240307@openai=claude-3-haiku-20240307,+deepseek-chat@openai=deepseek-chat,+flux-pro@openai=flux-pro,+o1-preview@openai=o1-preview,+o1-mini@openai=o1-mini

部署教程请参考历史文章《通过NextChat(ChatGPT-Next-Web)低成本给自己或客户部署GPT程序》

如果需要使用GPT或者Claude,推荐以下平台,支持超高并发,性价比高,稳定可用于生产环境: